We hebben eerder gezien dat een #(n\times n)#-matrix #A# van rang #n# enige plezierige eigenschappen heeft: volgens de stelling Inverteerbaarheid en rang bestaat de inverse van #A# en volgens Unieke oplossing en maximale rang heeft elk stelsel lineaire vergelijkingen met coëfficiëntenmatrix #A# precies één oplossing.

We hebben ook besproken dat het bepalen van de rang van een matrix mogelijk is door met rijen en kolommen te vegen naar de gereduceerde trapvorm en daarin de onafhankelijke rijen (of kolommen) tellen. We kunnen echter ook zien of de rang #n# is door van de #(n\times n)#-matrix de zogenaamde determinant te berekenen. Het berekenen van dit getal is vrij eenvoudig, maar de achterliggende theorie is wat ingewikkelder.

De determinant van een #(2\times 2)#-matrix

\[

A=\left(\begin{array}{cc} a & b \\ c & d \end{array}\right)

\] is het getal #a\cdot d-b\cdot c#.

De gebruikelijke notatie voor de determinant van #A# is #\det(A)# of \(

\left|\begin{array}{cc} a & b \\ c & d \end{array}\right|

\).

Als #A = \matrix{2&3\\ 4 &6}#, dan is \[\det(A) = 2\cdot 6- 3\cdot 4 = 0\]

De lineaire afbeelding #\mathbb{R}^2\to\mathbb{R}^2# met matrix #A# is dan en slechts dan inverteerbaar als #\det(A)\ne0#.

In dat geval is de inverse van #A# gelijk aan

\[A^{-1} =\dfrac{1}{\det(A)}\cdot \matrix{d&-b\\ -c&a}\]

Deze stelling inclusief bewijs zagen we eerder in De inverse van een matrix. Hier geven we een alternatief bewijs door na te gaan dat #\det(A)\neq 0 \Leftrightarrow \text{rang}(A)=2#.

Stel dat #\text{rang}(A)\lt 2#. Dan is ten minste één van de twee rijen van #A# afhankelijk van de andere. Stel dat de tweede rij een veelvoud is van de eerste, zeg #\rv{c,d}=\lambda \rv{a,b}#. Dan volgt \[\det(A)=a\cdot (\lambda b)-b\cdot (\lambda a)=0\] Het andere geval (waarin de eerste rij afhankelijk is van de tweede) kan net zo bewezen worden.

Omgekeerd: stel dat #\det(A)=0#. Als één van beide rijen gelijk is aan de nulvector, dan is deze rij afhankelijk van de andere en volgt direct dat #\text{rang}(A)\lt 2#. Vervolgens nemen we aan dat #\rv{a,b}\ne\vec{0}#. Als #a\neq 0#, dan volgt uit #a\,d=b\,c# dat #d=\frac{b\,c}{a}# en dus #\rv{c,d}=\frac{c}{a}\rv{a,b}#, zodat de tweede rij afhankelijk is van de eerste. Als #a = 0#, dan geldt #b\ne 0# en volgt uit #a\,d=b\,c# dat #c = 0#, zodat #\rv{c,d} =\frac{d}{b}\cdot\rv{a,b}# en zien we weer dat de tweede rij afhankelijk is van de eerste.

Tenslotte is eenvoudig na te rekenen dat \[A\, \matrix{d&-b\\ -c&a}=\matrix{a&b\\ c&d}\,\matrix{d&-b\\ -c&a} = \matrix{a\,d-b\,c&0\\ 0&a\,d-b\,c} = \det(A) \cdot I_2 \] waaruit volgt dat, als #\det(A)\ne0#, de matrix \(\frac{1}{\det(A)}\matrix{d&-b\\ -c&a}\) de inverse van #A# is.

Het getal #\det(A)# speelt ook een rol bij het oplossen van een stelsel #A\vec{x}=\vec{p}# in twee onbekenden: als #A_1# de matrix is die uit #A# verkregen is door de eerste kolom te vervangen door #\vec{p}#, en #A_2# de matrix is die uit #A# verkregen is door de tweede kolom te vervangen door #\vec{p}#, dan is de unieke oplossing van het stelsel

\[

\begin{array}{rcl}

ax_1 + bx_2 &=&p_1 \\ cx_1 + dx_2 &=&p_2

\end{array}

\] gelijk aan

\[

x_1 = \frac{\det(A_1)}{\det(A)}=\frac{p_1 d-bp_2}{ad-bc}, \quad

x_2 = \frac{\det(A_2)}{\det(A)}=\frac{ap_2-p_1 c}{ad-bc}

\] mits #\det(A)\neq 0#. Je kunt dit door narekenen direct afleiden, maar een fraai algemeen bewijs voor alle dimensies #n# komen we later tegen. Als #n=3# en #A# een #(3\times 3)#-matrix is, dan heeft #A\vec{x}=\vec{p}# een soortgelijke oplossing voor #x_1#, #x_2# en #x_3# in termen van de determinanten van #A#, #A_1#, #A_2# en #A_3#.

Een derde plek waar #\det(A)# een rol speelt, is bij oppervlakteberekeningen. Oppervlakte hebben we niet gedefinieerd, noch de subtiliteiten die spelen bij het gebruik van coördinaten daarbij. Wat we hier opmerken dient dan ook alleen als illustratie. De georiënteerde oppervlakte van een parallellogram opgespannen door #\rv{a,b}# en #\rv{c,d}# is gelijk aan #a\cdot d-b\cdot c=\det(A)#. Deze oppervlakte heet georiënteerd omdat de uitkomst ook negatief kan zijn, afhankelijk van de volgorde waarin we de vectoren opschrijven. De 'echte' oppervlakte krijgen we door de absolute waarde te nemen.

De uitdrukking #a\cdot d-b\cdot c# is niet lineair en lijkt daarmee buiten het kader van de lineaire algebra te vallen. Gelukkig is de uitdrukking wel multilineair. Bepaalde eigenschappen van de #(2\times 2)#-determinant staan model voor de generalisatie naar #(n\times n)#-determinanten.

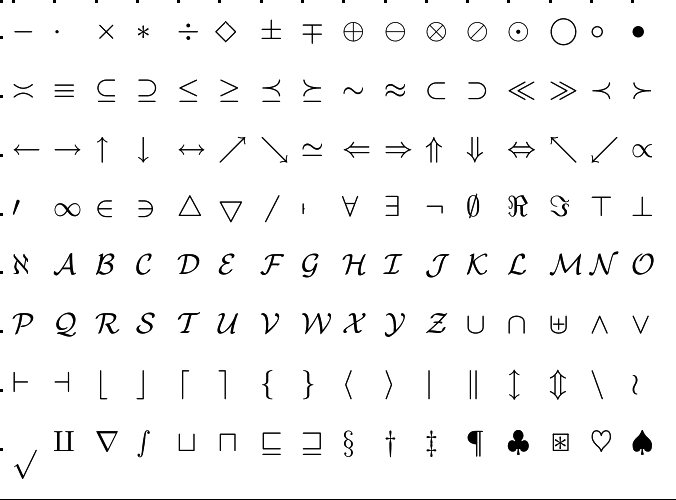

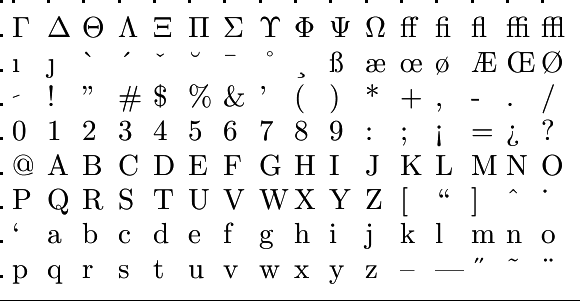

Vat de determinant op als functie van de twee rijen van de matrix: #\det(\vec{a}_1, \vec{a}_2)#. Dan voldoet #\det# aan de volgende drie eigenschappen (voor alle keuzen van vectoren en scalairen):

- bilineariteit (lineariteit in beide argumenten):

\[

\begin{array}{rcl}

\det(\lambda_1 \vec{b}_1 +\lambda_2 \vec{b}_2, \vec{a}_2 ) &=&

\lambda_1 \det(\vec{b}_1, \vec{a}_2) + \lambda_2 \det(\vec{b}_2 ,\vec{a}_2)\\

\det(\vec{a}_1, \lambda_1 \vec{b}_1 +\lambda_2 \vec{b}_2) &=&

\lambda_1 \det(\vec{a}_1, \vec{b}_1) + \lambda_2 \det(\vec{a}_1 ,\vec{b}_2)

\end{array}

\]

- antisymmetrie: #\det(\vec{a}_1,\vec{a}_2) =-\det(\vec{a}_2,\vec{a}_1)# (verwisseling van de twee vectoren introduceert een minteken); als de twee vectoren gelijk aan elkaar zijn, volgt hieruit #\det(\vec{a},\vec{a})=0#;

- normering: #\det(\vec{e}_1,\vec{e}_2)=1#.

De determinant is uniek in de zin dat als een functie op paren vectoren de genoemde drie eigenschappen van #\det# heeft, ze de determinantfunctie #\det# moet zijn.

Deze eigenschappen zijn gemakkelijk na te gaan. Zo volgt de tweede eigenschap uit

\[

\left|\begin{array}{cc} a_{11} & a_{12} \\ a_{21} & a_{22}\end{array}\right|

=a_{11}a_{22}-a_{12}a_{21} =-(a_{21}a_{12}-a_{22}a_{11})=-

\left|\begin{array}{cc} a_{21} & a_{22}\\ a_{11} & a_{12} \end{array}\right|

\]

Uniciteit: Stel dat #D# een functie op paren vectoren is die de genoemde drie eigenschappen van #\det# heeft. Dan geldt #D(\vec{a}, \vec{a})=0#. Vervolgens vinden we door gebruik te maken van de bilineariteit:

\[

\begin{array}{rcl}

D(\rv{a,b},\rv{c,d}) & =&D(a\vec{e}_1 + b\vec{e}_2,c\vec{e}_1 + d\vec{e}_2)\\ &&\phantom{xxx}\color{blue}{\text{rijvectoren uitgeschreven in termen van standaardbasis } \vec{e}_1,\,\vec{e}_2}\\

& =&aD(\vec{e}_1,c\vec{e}_1 + d\vec{e}_2)+ bD(\vec{e}_2,c\vec{e}_1 + d\vec{e}_2)\\ &&\phantom{xxx}\color{blue}{\text{lineariteit in eerste argument}}\\

& =&ac D(\vec{e}_1, \vec{e}_1)+ad D(\vec{e}_1,\vec{e}_2)

+ bc D(\vec{e}_2,\vec{e}_1)+bd D(\vec{e}_2, \vec{e}_2)\\ &&\phantom{xxx}\color{blue}{\text{lineariteit in tweede argument}}\\ & =& ad\,D(\vec{e}_1,\vec{e}_2) + bc\, D(\vec{e}_2,\vec{e}_1)\\ &&\phantom{xxx}\color{blue}{D(\vec{a}, \vec{a})=0}\\

& =& (ad-bc) D(\vec{e}_1,\vec{e}_2) \\ &&\phantom{xxx}\color{blue}{D(\vec{e}_2, \vec{e}_1)=-D(\vec{e}_1, \vec{e}_2)}\\ &=&ad-bc\\ &&\phantom{xxx}\color{blue}{D(\vec{e}_1, \vec{e}_2)=1}\\ &=&\det(\rv{a,b},\rv{c,d}) \\ &&\phantom{xxx}\color{blue}{\text{definitie van }\det}

\end{array}

\]

Het lijkt wat dikdoenerij om een eenvoudige uitdrukking als #a\cdot d-b\cdot c# te beschrijven met deze eigenschappen, maar in hogere dimensies is zo'n omschrijving absoluut noodzakelijk omdat de expliciete formules daar onhandelbaar voor berekeningen zijn.

De reden om deze berekening in deze simpele situatie te laten zien, is dat in het hoger-dimensionale geval eenzelfde soort berekening verschijnt, die we daar echter niet tot in detail zullen uitwerken.

Merk op dat het minteken ontstaat door een verandering van de volgorde van de vectoren in de voorlaatste overgang.

2-dimensionale determinanten

2-dimensionale determinanten